Ich habe dieser Tage ein einjähriges Jubiläum zu feiern: Ich bin seit einem Jahr Apple-frei. Und zwar komplett. Ich nutze auf meinen Rechnern Windows 7, auf meinem Telefon Symbian und auf den Tablets Android. Ich habe kein Gerät mehr mit iOS oder OS X. Und ich bin froh, Apple aus meinem Leben verbannt zu haben. Das war aber nicht immer so. Ich war nämlich mal ein richtiger kleiner Fanboy. Das ist vorbei – wie es dazu gekommen ist und warum mir Windows mittlerweile Spaß macht, das erzähle ich im Folgenden.

Zuerst aber möchte ich die Quelle meiner Inspiration zu diesem Post nennen: Der Chrisu hat in seinem Blog über Apple geranted – und er spricht mir aus dem Herzen. Etliches sehe ich ähnlich. Nur: Viele Geräte hatte ich, manche sogar gerne. Und keines würde ich wieder wollen oder heute nochmal kaufen.

Ich steige in den 1990er Jahren ein: Mein erster Mobilcomputer (Laptop traue ich mich nicht zu schreiben) war von Toshiba. Eine Nummer oder Bezeichnung weiß ich nicht mehr, das Gerät hatte eine vollwertige Tastatur und einen LCD-Bildschirm, das Netzteil war fest eingebaut und das ganze Gerät war höllisch schwer. Mein Papa hat es zu dieser Zeit von einem befreundeten Ingenieur geschenkt bekommen und wusste damit wohl auch nichts sinnvolles anzustellen – auf jeden Fall landete das Ding schnell bei mir und setzte Staub an. Diese Kiste war – wie erwähnt – unendlich schwer und staubte so über die Jahre vor sich hin, aber während meiner ersten Praktika habe ich das Ding dann aber doch mit auf Arbeit genommen, weil ich so vor Ort meine Berichte tippen konnte – auch wenn das Gerät selbst damals schon ziemlich veraltet war. Interessanterweise gab es zu genau diesem Computer einen Werbefilm und just diesen Film habe ich auf Youtube wiedergefunden und selbst wenn es mit dem eigentlichen Thema nichts zu tun hat, binde ich hier mal ein:

Den nächsten Rechner habe ich wieder geschenkt bekommen und da sind wir dann schon beim Mac: Es war ein PowerBook 5300ce von 1995, der aber am Ende des ausgehenden Jahrtausends immer noch ein akzeptables Arbeitsgerät darstellte. Ich will jetzt gar nicht zu tief einsteigen, nur sagen, dass sich (abgesehen von den Jahren 2004 bis 2008) immer ein paar Dosen in meinem Besitz befanden, wie auch ein iMac DV 400, ein PowerMac G4 MDD, ein iBook G4, ein MacBook und ein Mac mini. Mit letzterem hatte ich übrigens wahnsinnige Probleme.

Der Umstieg von Win ME und 2000 auf OS X war eine Revolution für mich. Aber der Umstieg von Windows ME zu XP war auch eine Revolution. Eine kleinere – aber gut. OS X hatte mich schnell im Bann: Es sah chic aus und war sehr performant, die Renderingzeiten der alten Kisten mit ihren IBM- bzw. Motorola-CPUs waren zum damaligen Zeitpunkt großartig. Dazu kommt, dass das Design und die Haptik der Geräte wirklich top war.

Und dann kommt noch was dazu, ich will hier ganz ehrlich sein: Damals war ein Mac cool. Und ein Statussymbol. Und Leute, die mit ihrem Computer ernsthaft arbeiten wollten, hatten einen Mac. Sich zur damaligen Zeit nicht um Viren, Würmer und Trojaner kümmern zu müssen, war wirklich eine feine Sache. Der Mac-Besitzer war gefühlt Mitglied in einem elitären Zirkel und wer sein iBook im Kaffeehaus auspackte, erntete neidische Blicke. Ich habe mich natürlich auch ganz toll gefühlt, weil ich zur damaligen Zeit diese wirklich tollen Statussymbolrechner hatte. Und ich will weiterhin ehrlich sein: Ich hätte diese tollen Rechner seinerzeit gar nicht gebraucht, konnte bei weitem nicht das aus ihnen herausholen, was möglich gewesen wäre. Aber ich hatte einfach stylische Macs.

Mein erster iPod war der der dritten Generation. Vierzig GB Musik dabei zu haben, eine weitere Revolution. Dieser iPod war damals – wie heute immer noch alles von Apple – sündhaft teuer und nach einem Jahr kaputt. Und Apple weigerte sich freilich, den iPod zu reparieren, denn nach einem Jahr ist die Gewährleistung vorüber. Schon damals „erpresste“ Apple seine Kunden: Wer eine zweijährige Garantie haben wollte, wie sie eigentlich jeder Elektronikhersteller hierzulande gewährt, muss bei Apple einen ebenfalls sündteuren „Care Protection Plan“ kaufen – ich schüttle heute immer noch den Kopf, dass ich diesen frechen Unsinn seinerzeit kommentarlos hingenommen habe.

Mit dem iPod der dritten Generation, der im Vergleich zu den heute gelieferten Geräten noch robust verarbeitet war, komme ich gleich zum nächsten Problem, zur Hardware: Diese ist immer schlechter geworden. Jedes neue Apple-Gerät, das ich kaufte, war von de Verarbeitung her deutlich minderwertiger als sein Vorgänger. Losgegangen mit den Qualitätsproblemen ist es nach meiner Erfahrung bereits im Jahr 2005. Der Umstieg vom PowerPC-Prozessor zu Intel-Prozessoren markiert für mich ebenfalls einen Punkt, ab den Qualität und Performance der Apple-Produkte merklich nachließen.

Nicht nachgelassen hat indes der Preis. Früher war ich gerne bereit, diesen Preis zu bezahlen, waren doch z.B. die G4-Rechner sehr solide verarbeitet. Man bekam, kaufte man einen Mac, Premium-Hardware. Damit war der Preis zwar immer noch vergleichsweise hoch, es rechnete sich aber durchaus. Inzwischen habe ich MacBooks gesehen, von denen ich mit Fug und Recht behaupten darf, dass sie wesentlich schlechter verarbeitet sind, als Aldi-Laptops. Meine letzten beiden Macs, das MacBook und der Mac mini sind ob der meinen geringen Ansprüchen nicht mehr genügenden Qualität der Hardware – wie auch nicht anders zu erwarten – sang- und klanglos abgeschissen. Ich glaube inzwischen, dass man derzeit bei Apple unterdurchschnittliche Qualität zu Premiumpreisen bekommt – da mache ich nicht mehr mit.

Im Sommer letzten Jahres gingen mir hinsichtlich der Apple-Hardware die Augen auf. Wie es dazu kam, will ich kurz erzählen: Mein Ende 2009 gekaufter Mac mini ging in die Knie – eine Reparatur wäre trotz des an der Performance gemessenen durchaus knackigen Anschaffungspreises unwirtschaftlich gewesen. Da der Mac mini sehr gedrungen mit viel Notebooktechnik gebaut ist (was ebenso für die iMacs gilt), ist eine Selbstreparatur auch nicht jedermanns Sache. Meine Idee war also, mir wieder einen großen PowerMac zu kaufen – sollte da etwas kaputt gehen, dann könnte ich in vielen Fällen immerhin selbst Hand anlegen. Der Preis war schnell ermittelt – 2100,- hätte der Rechner in halbwegs vernünftiger Ausstattung gekostet (mit viiiiieeeeeeel Luft nach oben). Dass es aber keinen PowerMac diesseits der 1500-Euro-Marke gibt, hat mich dann doch erstaunt. Nur zum Spaß guckte ich, was ein ähnlich ausgestatteter Windwos-PC kosten sollte – wirklich nur zum Spaß. Was ich da sehen musste, ließ mir quasi das Blut in den Adern gefrieren: Für einen nahezu gleichwertigen Rechner inklusive Windows 7 Professional von Lenovo wurden von einem Onlinehändler weniger als 500,- Euro aufgerufen. Ihr könnt mein Erstaunen mit Sicherheit teilen: Ein Rechner mit mindestens gleichwertiger Performance von einem namhaften Hersteller sollte deutlich weniger als ein Drittel des Apple-Preises kosten? Ich habe ausführlich nach dem Haken gesucht und keinen gefunden. Ich habe dann dieses „ThinkCentre“ bestellt – abends um 17 Uhr, tags darauf stand der Computer um 9 Uhr unter meinem Schreibtisch – bei Apple hätte ich seinerzeit 8 Werktage gewartet.

Das Ding tut für kleines Geld bis heute, was ich will. Warum ich nicht früher zu Windows zurückgefunden habe, liegt an Vista. Ich war auf Arbeit mit dem im Grunde stabilen aber eben auch angestaubten XP recht zufrieden. Auf Vista habe ich mich aus reiner Neugier gefreut, war dann aber, als ich das erste Mal an einem solchen Gerät saß, so enttäuscht, dass ich Windows nicht als Alternative auf dem Schirm behielt und kurzerhand wieder einen Mac kaufte.

Nun habe ich Windows 7, auf einem Rechner Home, auf dem anderen Professional. Mir wurde auch schon zu Ultimate geraten, ich wüsste aber den Mehrwert für mich nicht zu benennen.

Als ich von OS 10.4.x auf Win 7 umgestiegen bin, hatte ich arge Vorbehalte – zu Unrecht. Windows ist heute performanter denn je. Windows präsentiert sich logisch und ist bedienbar. Man kann Windows sogar sehen. Für das Geld, das der langsamste Einsteiger-Mac kostet, bekommt der Windows-Nutzer einen i7-Rechner mit allen Features. Nach einem Jahr kann ich sagen: Ich vermisse Apple nicht. Ich habe schnellere Rechner mit besserer Hardware. Ich stehe nicht mehr unter der Knute eines Konzerns, der immer dreckiger mit seinen Kunden umgeht – ich werde nicht mehr von Apple verarscht.

Das Ganze hat natürlich seinen Preis: Ich bin mit einem Windows-PC freilich tierisch uncool. Hipster, SEO-Berater oder „was mit Medien“-Fuzzi wird man mit so einer Dose freilich nicht. Die richtige Sexiness hat nur der Mac-Besitzer, schon klar. Wider Erwarten ist mein Ego noch ok – aber wer weiß, wie lange das ohne Apple-Karma noch geht.

Obwohl: Manchmal erwische ich mich, wie ich fast etwas spöttisch auf Mac-Fanboys herabblicke. Dabei war ich doch selber mal einer. Klar kann man mit jetzt Arroganz vorwerfen. I used Macs before it was cool. Aber diese kognitive Dissonanz hält selbst der härteste Fanboy nicht aus. Auf der einen Seite bietet OS X gegen Windows 7 in Bestfall noch einen Designvorteil, auf der anderen Seite ist Apple als Konzern eigentlich nicht mehr akzeptabel: Auf der einen Seite steht da diese hochgradig lächerliche Patenttrollerei. Diese Nummer mit Samsung ist nicht mehr lächerlich sondern absurd. Richtig übel ist zudem, dass man mit iPhone und iPad nur Software benutrzen darf, die auch Apple gefällt. Wer heute sein iPhone aus der Tasche zieht, zeigt also, dass er sich gerne bevormunden lässt – herzlichen Glückwunsch. Interessant ist im Kontext dessen besonders, dass diese App-Nummer mehr und mehr auch auf dem Desktop raumgreift. Dafür bin ich mir wirklich zu schade.

Die Hardware von Apple ist billige Massenware, die Software im Kern schon gut abgehangen und den Service darf man wohl getrost als nicht so besonders bezeichnen – da fragt man sich, warum Apple-Produkte so teuer sind. Ich nehme an, dass man hier das Marketing blecht. Das ist für den Hipster schon in Ordnung so. Für mich nicht.

Wende ich also den Blick von meinen vergangenen Fehltritten und dem Fallobst hin zu Windows. Microsoft war ja dereinst unser innig gehassliebter Gegner, den es bis aufs Messer zu „bekämpfen“ galt. Gates, der reichste Mann der Welt, unantastbar und unsympathisch – ein Milchbubi. Steve Ballmer war so eine Art Reiner Callmund der Ammi-IT und machte eine nicht immer so gute Figur… Mit dem virtuellen Holzhammer versuchte Microsoft uns seinerzeit den Internet Explorer, ein Einfallstor für allerhand digitales Ungeziefer, zu verplätten. Und was auf unseren Rechnern lief, wurde fleißig nach Redmont, CA „heimtelefoniert“, es sei denn, man stopfte mit Software von Schlage eines „XP AntiSpy“ seinem eigenen Rechner in dieser Hinsicht das Maul. Und bei meinen Windowskisten hatte ich immer eine Aufwand: Zone Alarm aktualisieren, Virenscanner aktualisieren, immer wieder Treiber aktualisieren und trotzdem wurde der Rechner immer langsamer und langsamer. Wer Software öfter mal in der Demoversion ausprobierte, war halbjährlich gezwungen, die Kiste neu aufzusetzen, wollte er nicht davor verschimmeln.

Microsoft zu bashen war einfach in, der Fairness halber muss aber auch gesagt sein, dass Microsoft es einem nicht besonders schwer gemacht hat. Kurz nach dem Umstieg habe ich Windows auch nicht vermisst, das spricht bei genauerer Betrachtung auch für OS X – aber hin und wieder sind mir dann doch die ein oder anderen Unzulänglichkeiten aufgefallen. Mit dem Umstieg auf die Intel-Architektur ging eine Gefühl der Stabilität verloren, in der ganzen langen Zeit, in der ich Macs nutzte, schlug ich mich mit üsseligen Audioeditoren herum, weil es z.B. Sound Forge nicht für den Mac gab und Digas auch nicht. Vom Mac zu streamen war dann auch eine ziemliche Scheiße. Eine vernünftige Playout-Software am Mac? Zumindest damals nicht vorhanden. Irgendwann kaufte ich mir ein Vista-Gerät – und zwar sofort, als Vista herauskam. Ich wollte so den Mac-Frust hinsichtlich fehlender vernünftiger Enterprise-Software entgehen. Das klappte aber nicht, denn Vista war noch übler als der Mac. In meiner Erinnerung ist von Vista eigentlich nur geblieben, dass dieses OS Ressourcen gefressen hat wie Sau und ziemlich oft wegschmierte. Allerdings: Das war halt bei mir so, möglicherweise war mein System auch gehörig misskonfiguriert (wozu Vista ebenfalls einlud).

Wie vorhin schon gesagt: Ich habe mir von Windows 7 nicht viel erwartet – bin aber über einige Punkte echt begeistert: Zuerst muss ich hier die gute Abwärtskompatibilität nenen: Ich habe noch einige Software aus alten Tagen, die tut, was ich will. Bis zu XP ist das alles abwärtskompatibel und zwar performant! Da mag im Hintergrund eine Kompatibilitätsmaschinerie anspringen – der User kriegt davon nichts mit. Das ist schon extrem gut. Zum Vergleich: Ich konnte meine Macs nie auf Lion updaten, weil ich sonst meine alten universal binary-Programme nicht mehr hätte nutzen können. Desweiteren gefällt mir das Prinzip der Bibliotheken gut, die Suche bei Windows hat inzwischen eine akzeptable Geschwindigkeit (hier war der Mac immer besser!) und auch die Vorschaufunktionen im Explorer sind inzwischen richtig gut. Ich hatte früher Windows als ein System in Erinnerung, das schon bei der Erstinstallation mit Zeug wie Windows Mail, dem Movie Maker und anderem Krempel überfrachtet war. Hier nimmt sich Win 7 schlanker aus, das honoriere ich.

Was weiterhin sehr sehr gut ist: Ältere Hardware läuft flott mit 7, 64-Bit-Geräte rocken geschwindigkeitsmäßig die Sau. Ich bekomme also für einen älteren Rechner, der seinen Job durchaus noch tut, ein modernes System und nutze mit dem selben System die Leistung neuer Geräte voll aus. Und so kann ich dank 7 auch mit eher spärlicher Neu-Hardware gut arbeiten. Beispiel gefällig? Netbooks – sofern sie kein Vermögen kosten sollen, sind mit ihren kleinen Atom-Prozessorchen unter Vista nie sinnvoll benutzbar gewesen und selbst bei XP war der Spaß begrenzt. Wer sauber mit einem solchen 1,6 GHz-Atom-Dingli arbeiten will, braucht entweder Linux – oder 7. Ich sag jetzt mal ganz frech: Netbooks machen erst seit 7 Spaß und man ist damit um Welten produktiver als mit einem Tablet.

Freilich gibts auch Sachen die nicht so schön sind – zuerst einmal gehört dazu, dass im Schnitt 30 Euro im Jahr für die Lizenz des Virenscanners ausgebe. Der von Windows selbst soll gar nicht mal so übel sein, aber irgendwie will ich doch dem All-inclusive-Schutzpaket mehr vertrauen und das Gepopuppe der Freewarescanner würde mir zu sehr auf den Zeiger gehen. Auch das Java, Flash und besonders Acrobat gefühlt im Stundentakt um Updates betteln, nervt. Über Adobe Air habe ich mir schon die Platze geärgert. Aber da kann im engeren Sinne Windows nichts dafür.

Gewonnen habe ich aber für wenig Geld eine schnelle Maschine die tut, was sie soll. Ich bin also mit Windows zufrieden. Und zwar wider Erwarten.

Zum Schluss dieser sehr subjektiven Betrachtung, die sich dann irgendwie doch zu einem Rant gegen die Fallobstfabrik ausgewachsen hat, will ich auf das Thema noch ein wenig globaler schauen: Zuerst einmal finde ich diese Patentnummer – besonders die Causa Apple vs. Samsung hochgradig peinlich. Mich wundert nun nicht, dass Apple in Ammiland den Prozess gegen Samsung gewonnen hat – wer sich daüber ernsthaft gewundert hat, der möchte jetzt einfach mal das Wort „Protektionismus“ googeln und weiß dann im Groben Bescheid. Und mit der Realität hat das Urteil auch nichts zu tun, denn wer das zweier Galaxy von einem iPhone 4 nicht unterschieden kriegt, merkt auch den Unterschied zwischen einem Cheseburger und einem Mauerziegel nimmer.

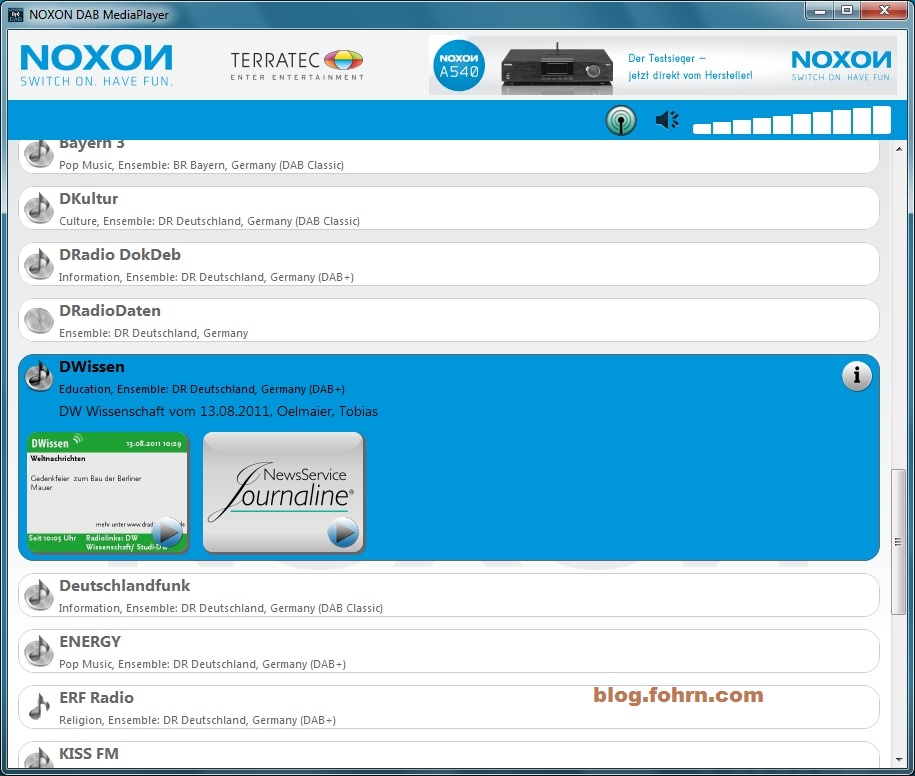

Nebenefekt ist, dass Apple bei mir im Ansehen noch tiefer gesunken ist. Wir haben uns daran gewöhnt, dass Innovationen irgendwann Modifikationen erfahren und durch Mitbewerber in der Fläche verfügbar werden. Und dann kommen eben neue Innovationen. So funktioniert Fortschritt eben. Aus meiner Perspektibe wurde hier auch nicht nachgefeilt sondern sich an gängig gewordener Technologie orientiert. Dagegen zu klagen wird auf Dauer nichts bringen – zumal Apple sich ja durch unterschiedliche Märkte klagt. Klar ist auch: Mit Samsung ist ein Hardwarehersteller ins Fadenkreuz geraten, der zeigen konnte, dass sich mit Andoid massenkompatible Geräte bauen lassen. Ziel ist m.E. nicht Samsung sondern Google. Nur derzeit kommt Apple gegen Google nicht an. Und selbst wenn – das wirkliche Geschäft wird ja doch in China gemacht. Was bedeutet das? In meinen Augen muss Apple jetzt mit iPhone und iPad verdienen, was verdienbar ist, denn in wenigen Jahren ist das iPhone und iPad nicht mehr interessant. Android hat das Rennen ja schon jetzt gemacht – in extrem kurzer Zeit! Erinnert ihr Euch noch an das erste Google-Telefon? Das kam am 2. Februar 2009! Das sind ziemlich genau dreieinhalb Jahre, die Android gebraucht hat, um iOS haushoch zu knacken. Berücksichtigt man im diesem Zusammenhang noch die Lebensdauer der Produkte und die Marktsättigung und bezieht in die Betrachtung mit ein, dass das iPhone wegen seiner massenhaften Verbreitung auch als Statussymbol nicht mehr so recht taugt, bekommt man schnell das Gefühl, dass Apple jetzt – gegenwärtig – das Geld verdienen muss. Über Bande hat das freilich auch Auswirkungen auf Microsoft – die verdienen nämlich pro Android-Lizenz etwa 5 Dollar (Quelle: DRadio Wissen). Mit jedem verlorenen Prozent Marktanteil nährt Apple seine zwei wichtigsten Konkurrenten.

Apple-Chef Steve Jobs hat vor seinem Tod alles daran gesetzt, das konkurrierende Smartphone-Betriebssystem Android von Google zu „vernichten“. Er wollte einen „Atomkrieg“ dagegen führen. (Quelle)

Mich wundert das nicht. Nur: Mit der Politik, die Jobs fuhr und die jetzt noch gefahren wird, kann seitens Apple nicht mehr gewonnen werden. Ich bin überzeugt, dass man das weiß und daher im Endeffekt nur versucht, Verkaufsverbote zu erwirken um ad hoc das Geld zu machen, das (noch) zu machen ist. Eine langfristige Stategie kann ich nicht erkennen. Die Apple-Patenttrollerei könnte aber auch einen Imageschaden bedeuten, denn wenn Samsug-Telefone dem iPhone in der Tat so ähnlich seien wie behauptet, dann müsste ich ja bescheuert sein, um bei Apple für ein ähnliches Telefon viel Geld auszugeben – die Katze beißt sich in den eigenen Schwanz.

Wer also sein Geld mit Apple-Aktien verbrennen will – nur zu. Mich würde es jedenfalls nicht wundern, wenn Apple das zweite Facebook wird.

Neben iOS und Android ist ja Win 7 Mobile das dritte große System auf dem Handy – aber auch hier will ich mich nicht zu Jubelstürmen hinreißen lassen. Der Kardinalsfehler im Mobilfunkmarkt wurde in meinen Augen von Nokia begangen – indem man sich entschied, sowohl Symbian wie auch Meego nicht mehr weiterzuentwickeln.

Zum Thema Tablet nur einige wenige Gedanken: Die Funktionen, die sich auf so einem Gerät sinnvoll nutzen lassen, sind limitiert. Es bedarf schon heute kaum noch schnellerer Hardware, surfen und Video schauen funktioniert ja. Vielleich werden in Zukunft die Grafikchips dieser Geräteklasse noch besser, das würden die Gamer sicherlich dankbar annehmen. Vielleicht kommt in den nächsten Jahren 3D aufs Tablet (obwohl aufgrund der Größe da der Spaßfaktor übersichtlich bleiben dürfte). Das war es dann aber auch. Insofern ist man auch hier weder auf „Innovationen“ von Apple oder Microsoft angewiesen – Android wird auch hier das Rennen machen.

Nicht dass jetzt der Eindruck entstünde, ich wäre ein Android-Fanboy – wirklich nicht. Ich finde Android per se ganz chic und gut benutzbar – sehe die tiefe Verquickung mit Google jedoch als ein wesentliches Argument, um um Android einen Bogen zu machen. Einige Kompromisse wird es aber geben müssen, denn recht viel mehr Auswahl gibt es nicht. Ich bin zwar sehr auf bada 3.0 gespannt – aber ich rechne mir da keine großen Chancen aus – zuviele App-Entwickler unterstützen bada nicht. Ich kann mir gut vorstellen, dass sich bada in der Nische der Einsteigersmartphones hält – nur da will ich persönlich halt nicht hin, eher würde ich mir ein gebrauchtes Telefon kaufen.

Sollte ich diesen Rant jetzt mit dem Rat beschließen, sich Microsoft zuzuwenden? Nein, pauschal kann man das nicht sagen und hinsichtlich der derzeitigen Entwicklung sollte jeder die hier viel zu kurz gekommene Alternative Linux in seinen uunterschiedlichen Ausführungen und Distributionen ansehen. Microsoft ist mit seiner „Heimtelefonierpolitik“ nämlich auch nicht so zivil unterwegs, wie man annehmen möchte. Trotzdem: Wer sich zu Linux nicht durchringen kann (was ich verstehe), der bekommt das „Fehlverhalten“ von Wndows immerhin noch regelhaft in den Griff. Bei den Apple-Geräten ist man da eher verloren.